| 论文题目(英) | SCAM! Transferring humans between images with Semantic Cross Attention Modulation |

| 论文题目(中) | SCAM! 基于语义交叉注意调制的图像间人转移 |

| 发表时间 | 22-10-10 |

| 论文方向 | 给定一个源和一个目标主体,主体转移的思想是让源主体无缝地替换目标图像中的目标主体。目标图像应该保持相同的背景,相同的主体和对象之间的相互作用,和相同的空间配置,以考虑可能的遮挡。 |

| 论文创新点 | 1. 提出了语义交叉注意(SCA),它在一组潜在的(每个都链接到一个语义区域)和一个图像特征图之间执行注意。 SCA 限制了注意力,例如潜在的只关注图像特征图上与相关语义标签相对应的区域。 2. 引入了 SAT 操作和编码器(Semantic Attention Transformer),它依赖于交叉注意力来决定在图像中收集哪些信息以及哪些潜在信息,从而允许对更丰富的信息进行编码。 3. 提出SCAM-Generator(以 SCAM 命名),它使用 SCAM-Operation 调制特征图,允许每个像素关注语义上有意义的潜在。 |

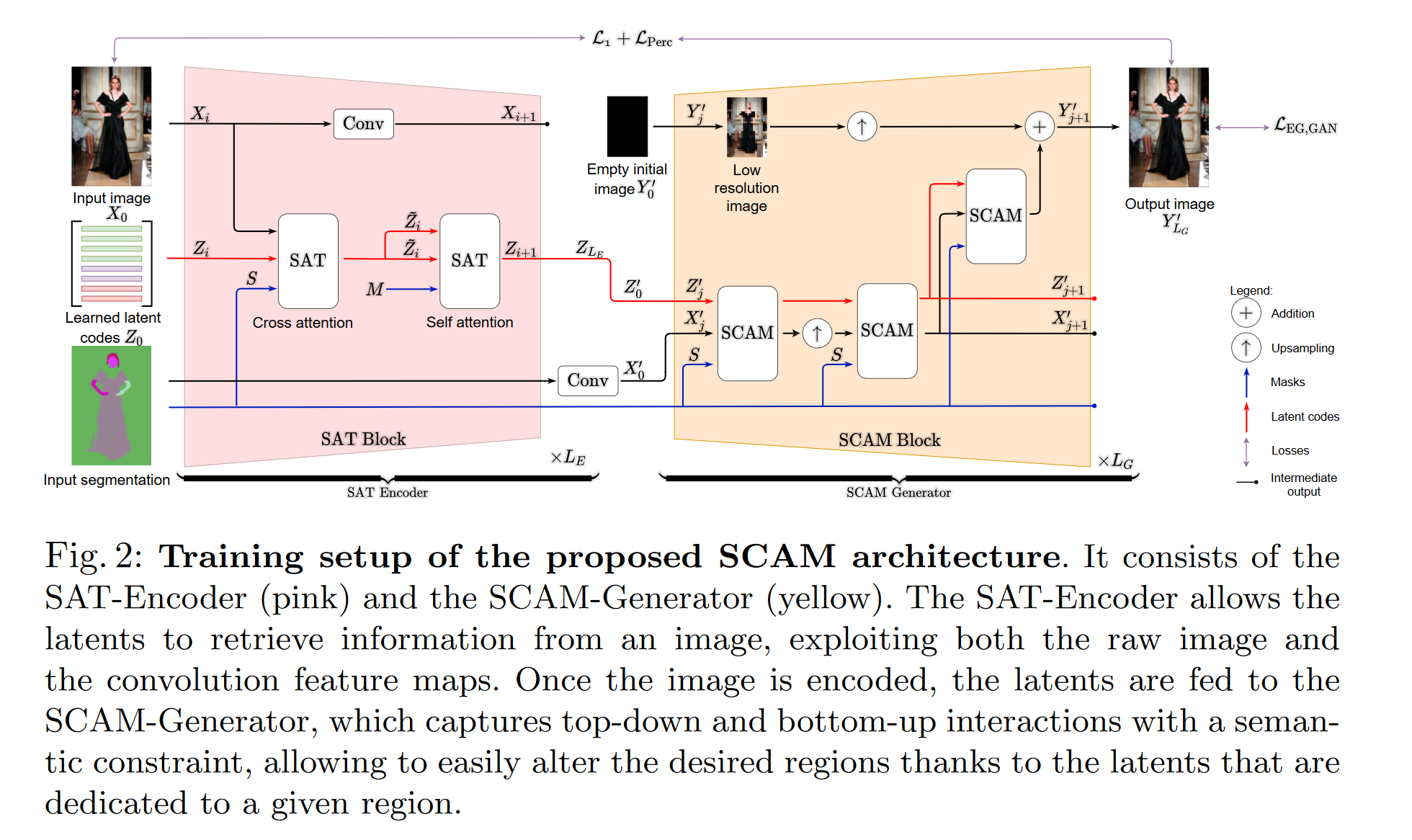

| 论文方法 |  > 拟议的 SCAM 架构的训练设置。 它由 SAT-Encoder(粉色)和 SCAM-Generator(黄色)组成。 SAT-Encoder 允许 latents 从图像中检索信息,同时利用原始图像和卷积特征图。 一旦图像被编码,隐码被馈送到 SCAM-Generator,它捕获具有语义约束的自上而下和自下而上的交互,由于专用于给定区域的潜伏,允许轻松改变所需区域。 SCAM 通过每个语义区域具有多个潜在对象来捕获语义区域内的精细图像细节。这可以在语义标签内捕获无监督的语义信息,从而可以更好地处理粗略的语义标签,例如背景。SCAM可以生成更复杂的背景,在主题迁移和语义重建任务上都优于SEAN。 |

| 方法效果 |  |

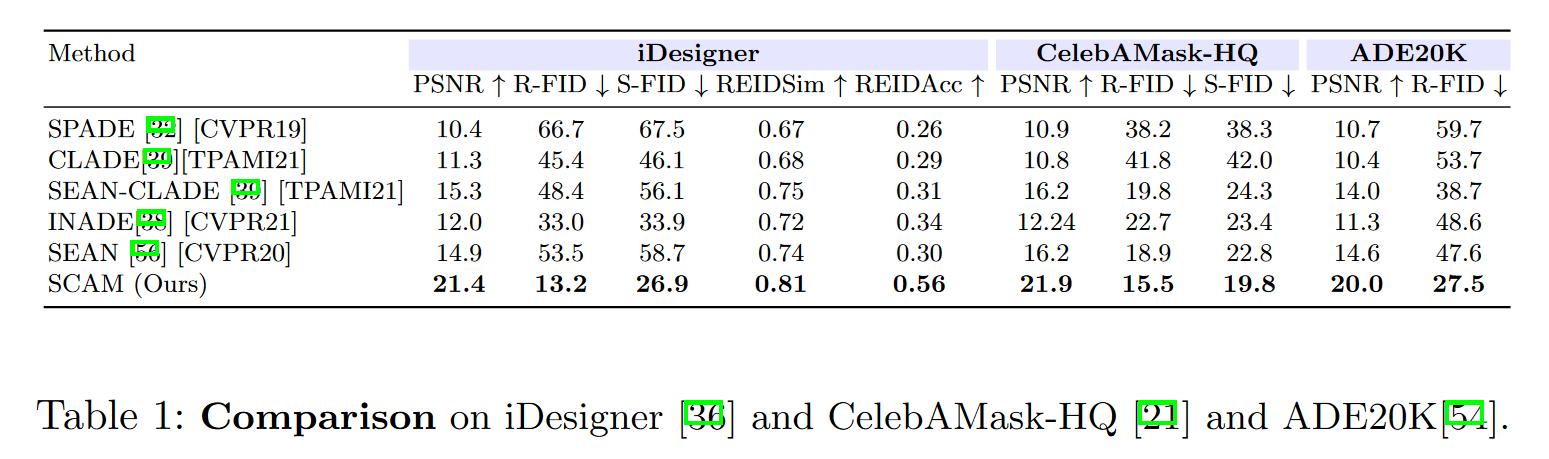

| 论文数据集 | iDesigner 包含来自设计师时装秀的图像,包括 50 位不同的设计师以及 50k 训练和 10k 测试样本。 我们用 [24] 分割人体部位,然后合并标签以结束:面部、身体和背景标签。 > 24. Li, P., Xu, Y., Wei, Y., Yang, Y.: Self-correction for human parsing. In: IEEE TPAMI (2020) CelebAMask-HQ 包含来自 CelebA-HQ 的名人面孔,带有 28k 训练和 2k 测试图像,标记有 19 个高质量语义标签。 ADE20K 包含具有 20k 火车和 2k 测试图像的不同场景图像。 这些图像标有 150 个高质量的语义标签。 Metrics. 我们使用 PSNR、重建 FID (R-FID) 和交换 FID (S-FID)。 R-FID 被计算为训练集和重建测试集之间的 FID,而 S-FID 是在测试集和在测试集上计算的一组主题转移图像之间。 我们介绍了在重新识别网络 的潜在空间中计算的 REIDAcc 和 REIDSim。 REIDSim 计算主题图像和主题传输图像之间的平均余弦相似度。 REIDAcc 占转移主体的余弦相似度与主体的余弦相似度高于与背景的图像的比例。 |

| 论文总结 | SCAM 的架构贡献是:首先,语义交叉注意 (SCA) 机制在特征和一组隐变量之间进行注意,限制它们只关注语义有意义的区域; 其次,语义注意转换器编码器(SAT)基于语义注意掩码检索信息; 第三,语义交叉注意调制生成器(SCAM)执行基于语义的生成。 SCAM 通过利用每个语义区域的多个隐变量并在编码和解码阶段提供更精细的潜在向量编码来设置最新的技术水平。 |

| 论文公式 | $SCA(I_1,I_2,I_3)=\sigma(\frac{QK^T\odot I_3+\tau(1-I_3)}{\sqrt{d_{in}}})V, \tag{1}$ $I_1,I_2,I_3$是输入,其中$I_1$参与$I_2$,并且$I_3$强制来自 $I_1$ 的标记仅参加来自 $I_2^{[1]}$ 的特定标记的掩码,$Q=W_QI_1,K=W_KI_2 和 V=W_VI_2$查询,键和值,和$d_{in}$内部注意力维度。 我们使用三种类型的 SCA。 (a) 具有像素 X 参与潜在 Z 的 SCA:SCA(X, Z, S),其中 $W_Q\in \R^{n\times d_{in}}和 w_K,W_V\in \R^{m \times d_{in}}$。 这个想法是强制来自语义区域的像素参加与相同标签相关联的隐变量。 (b) 具有潜在 Z 参与像素 X 的 SCA:SCA(Z, X, S),其中 $W_Q\in \R^{m\times d_{in}},w_K,W_V\in \R^{n \times d_{in}}$。 这个想法是在语义上掩盖注意力值,以强制隐变量参与语义对应的像素。 (c) 具有潜在 Z 的 SCA:SCA(Z, Z, M),其中 $W_Q,W_K,W_V\in\R^{n\times d_{in}}$。 我们将这个隐变量表示为$M\in\N^{m\times m}$,如果隐变量 i 的语义标签与隐变量 j 的语义标签相同,则 $M_{latents}(i,j)=1$否则$=0$。 这个想法是让隐变量只参与共享相同语义标签的隐变量。 SAT-Block 由三个部分组成:两个 SAT-Operations 和一个 strided convolution。 SAT-Operations 是类似 transformer 的操作,用我们提出的 SCA 取代了自注意力。 它们被定义为: $$ SAT(I_1,I_2,S)=LN(f(LN(SCA(I_1,I_2,S)+I_1))+I_1),\tag{2} $$ LN 是层范数,f 是一个简单的 2 层前馈网络。 第一个 SAT-Operation,SAT(X, Z, S),让潜网络从图像特征图中检索信息(3.1 中的案例 (b))。 第二个 SAT-Operation,SAT(Z, Z, M),在自注意设置中使用 SCA 精炼潜伏,其中潜伏自我关注,保持语义限制(来自 3.1 的案例 (c))。 跨步卷积对前一层图像特征图进行编码,减少其空间维度。 SCAM-Operation 由三部分组成:(a) the latent SAT(b) the feature SCA(c) the Modulation operation (a) The latent SAT. 它使用 SAT 操作根据当前特征图更新当前隐变量 $Z'_{in}$: $Z'_{out:=SAT(Z'_{in},X'_{in},S)}$。由于 SAT 内部的 SCA 操作,这允许在执行隐变量语义约束的同时进行隐变量细化。 (b) The feature SCA 执行隐变量的图像注意:它使用 SCA 将潜在信息合并到像素/特征。 给定 $X'_{in}$,SAT-Operation Z'out 的输出隐变量和掩膜 $S$,它输出 $X'_{SCA}$: $$ X'_{SCA}=SCA(X'_{in},Z'_{out},S).\tag{3} $$ (c) The Modulation operation 将图的$X'_{in}$ 和来自 SCA 的 $X'_{SCA}$ 作为输入,并输出通过卷积层 $g(.)$ 产生最终输出图像特征 $X'_{out}$的特征。 它被定义为: $$ X'_{out}=g(\gamma(X'_{SCA})\odot IN(X'_{in})+\mu (X'_{SCA})+N).\tag{4} $$ 它由 $\gamma(.)$ 和 $\mu(.) $运算符组成,用于确定调制操作(the modulation operation)的比例和偏置因子。我们使用实例归一化(IN)来执行特征图归一化。在之后,我们还添加了噪声 $N\in \R^{n\times C}$,其中 $N ∼ N (0, \sigma^2I_{n\times C}) $和 $\sigma$学习参数。 这鼓励modulation考虑随机变化。 |