Towards Real-time Traffic Sign and Traffic Light Detection on Embedded Systems

面向嵌入式系统的实时交通标志和交通灯检测

摘要

摘要-交通标志和交通灯检测的最新工作集中在提高复杂场景下的检测精度,然而许多工作无法提供实时性能,特别是在计算资源有限的情况下。在这项工作中,我们提出了一个简单的基于深度学习的端到端检测框架,有效地解决了交通标志和交通灯检测固有的挑战,如小尺寸、大类别和复杂道路场景。我们使用TensorRT优化检测模型,并与Robot Operating System集成部署在Nvidia Jetson AGX Xavier上作为我们的嵌入式设备。整个系统实现了63帧/秒的高推理速度,证明了系统的实时性。此外,我们还介绍了Cey Ro,这是第一个针对斯里兰卡背景的大规模交通标志和交通灯检测数据集。我们的数据集包括7984张总图像,10176个交通标志和交通灯实例,涵盖了70个交通标志和5个交通灯类。该图像具有1920 × 1080的高分辨率,可捕获不同天气和光照条件下的各种具有挑战性的道路场景。我们的工作在https://github.com/oshadajay/CeyRo.上公开

TensorRT

- TensorRT是一种高性能深度学习推理优化器和运行时加速库,可以为深度学习应用提供低延迟、高吞吐率的部署推理。

- TensorRT可用于对超大规模数据中心、嵌入式平台或自动驾驶平台进行推理加速。

- TensorRT现已能支持TensorFlow、Caffe、Mxnet、Pytorch等几乎所有的深度学习框架,将TensorRT和NVIDIA的GPU结合起来,能在几乎所有的框架中进行快速和高效的部署推理。

- 一般的深度学习项目,训练时为了加快速度,会使用多GPU分布式训练。但在部署推理时,为了降低成本,往往使用单个GPU机器甚至嵌入式平台(比如 NVIDIA Jetson)进行部署,部署端也要有与训练时相同的深度学习环境,如caffe,TensorFlow等。

由于训练的网络模型可能会很大(比如,inception,resnet等),参数很多,而且部署端的机器性能存在差异,就会导致推理速度慢,延迟高。这对于那些高实时性的应用场合是致命的,比如自动驾驶要求实时目标检测,目标追踪等。

为了提高部署推理的速度,出现了很多模型优化的方法,如:模型压缩、剪枝、量化、知识蒸馏等,这些一般都是在训练阶段实现优化。

而TensorRT 则是对训练好的模型进行优化,通过优化网络计算图提高模型效率。

Robot Operating System机器人操作系统 ROS

- ROS是一个机器人领域的元操作系统。也就是说,它并不是真正意义上的操作系统,其底层的任务调度、编译、设备驱动等还是由它的原生操作系统Ubuntu Linux完成。

- ROS实际上是运行在Ubuntu Linux上的亚操作系统,或者说软件框架,但提供硬件抽象、函数调用、进程管理这些类似操作系统的功能,也提供用于获取、编译、跨平台的函数和工具。

- ROS的核心思想就是将机器人的软件功能做成一个个节点,节点之间通过互相发送消息进行沟通。这些节点可以部署在同一台主机上,也可以部署在不同主机上,甚至还可以部署在互联网上。ROS网络通信机制中的主节点(master)负责对网络中各个节点之间的通信过程进行管理调度,同时提供一个用于配置网络中全局参数的服务。

- ROS是松耦合软件框架,利用分布式通信机制实现节点间的进程通信。ROS的软件代码以松耦合方式组织,开发过程灵活,管理维护方便。

- ROS具有丰富的开源功能库。ROS是基于BSD(Berkeley Software Distribution,伯克利软件发行)协议的开源软件,允许任何人修改、重用、重发布以及在商业和闭源产品中使用,使用ROS能够快捷地搭建自己的机器人原型。

引言

交通标志和交通信号灯通过向驾驶员提供必要的信息使其在道路上安全行驶,在调节交通方面起着至关重要的作用。因此,检测这两个要素成为自动驾驶汽车和高级驾驶辅助系统( Advanced Driver Assistance Systems,ADAS )开发中的一项基本感知任务。由于几个原因,开发鲁棒的检测算法可能是一项具有挑战性的任务。交通标志和交通信号灯通常占据典型街景图像的一小块区域。交通标志与其他类似物体如广告牌和广告牌很难区分。 算法应该对遮挡、光照变化、天气变化以及交通标志随时间的恶化具有鲁棒性。在应对这些挑战的同时,以有限的计算资源提供实时性能对于检测系统至关重要。

在交通标志和交通灯检测方面,早期的工作主要集中在基于传统图像处理的技术和基于机器学习的算法上。然而,这些实现大多是在高端图形处理器( GPU )上进行的,较少关注在嵌入式系统上提供实时性能,这对于自动驾驶汽车和ADAS的实现都至关重要。

在这项工作中,我们提出了一个端到端的、基于深度学习的交通标志和交通灯检测框架,该框架对具有挑战性的道路场景具有鲁棒性,并在嵌入式系统上展示了实时性能。我们首先创建了CeyRo交通标志和交通灯数据集,该数据集由70个交通标志和5个交通灯类的7984张图像组成。我们的数据集包括10176个交通标志和交通灯实例,涵盖了各种具有挑战性的城市、郊区和农村道路场景。

我们的交通标志和交通灯检测管道包括两个阶段:

- 考虑超类的原始图像中交通标志或交通灯的检测或定位。

- 将每个检测分类到各自的类中。

针对检测任务,我们训练并评估了两种最先进的目标检测器Faster R-CNN 和SSD 的性能;针对分类任务,我们训练了一个单独的ResNet-18分类器。

然后使用TensorRT优化检测器和分类器模型,并与机器人操作系统( Robot Operating System,ROS ) 集成,作为交通标志和交通灯检测系统部署在Nvidia Jetson AGX Xavier设备上。整个系统具有很好的实时性,推理速度达到每秒63帧( FPS )。

综上所述,我们的贡献有三:

- 我们介绍了CeyRo:斯里兰卡第一个用于交通标志和交通灯检测的大规模数据集。

- 我们评估了使用基于两阶段卷积神经网络的模型架构用于交通标志和交通灯检测任务的方法,并在速度和准确性方面提供了结果。

- 通过将训练和优化的模型部署在嵌入式系统上,并与ROS生态系统集成,我们展示了我们的检测框架实时执行的能力。

相关著作

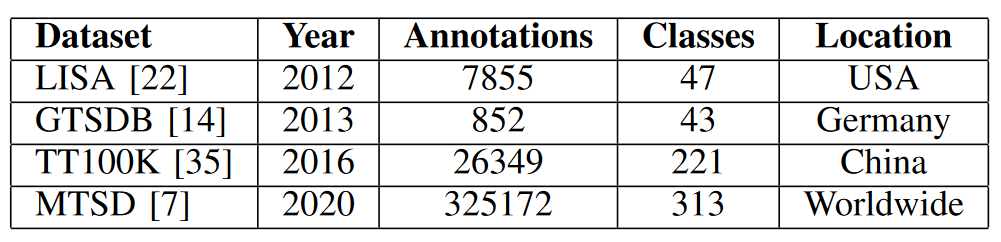

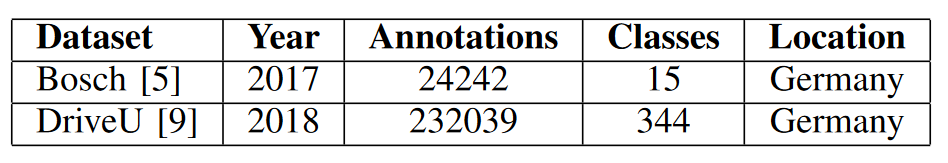

传统的基于图像处理的算法,以及基于深度学习的方法,已被用于交通标志检测和交通灯检测任务。大规模、高质量的视觉数据集的可用性已成为这些算法发展的关键因素,尤其是在深度学习领域。广泛使用的公开交通标志检测和交通灯检测数据集分别如表1和表2所示。

表I:交通标志检测基准数据集。

表2:交通灯检测基准数据集。

传统的基于图像处理的方法,如基于颜色、比例和形状的滤波和手工特征提取已经在[ 24 ]和[ 6 ]中用于交通标志检测和识别。同样,对于交通信号灯,文献[11]使用了颜色和形状等交通信号灯的显著特征,而文献[4]使用了HOG特征。基于机器学习的技术如支持向量机( SVMs )和随机森林已经用于交通标志分类[21]和[6]。Hidden Markov models和SVM在文献[11]和文献[17]中被用作基于机器学习的交通灯检测和分类技术。尽管这些方法的计算复杂度较低,但与最近的基于深度学习的方法相比,它们的使用场景有限,在具有挑战性的环境中表现不佳。

文献[35]提出了一种鲁棒的端到端卷积神经网络,其在TT100K数据集上的性能优于当前最先进的目标检测器,尤其是在小交通标志检测方面。交通标志检测与识别问题随着类别数的增加而变得复杂。文献[33]采用Mask R-CNN [12]架构对约200个交通标志类进行检测和识别。Seg-U-NET [18] 遵循基于语义分割的方法,其中结合了两种最先进的分割架构来检测交通标志,并使用单独的分类器进行识别。

文献[ 19 ]使用由生成器网络和判别器网络组成的感知生成对抗网络( GAN )来检测更高精度的小交通标志。考虑到基于深度学习的交通灯检测方法[ 5 ],引入了基于YOLO [27]的检测网络和小型分类网络来准确检测和分类交通灯。文献[3]在DriveU [9]数据集上使用基于Fast R-CNN [10]的网络结构进行交通灯检测。

上述算法几乎都采用了高端计算平台,在嵌入式系统上实现交通标志和交通灯检测系统还不是一个广泛研究的领域。文献[ 30 ]利用Xlinix Spartan-3A DSP FPGA设备,采用基于颜色的检测算法识别感兴趣区域并将路标分为4类。文献[34]使用Artix-7 FPGA器件实现了一种并行优化的AdaBoost检测算法,用于实时交通灯检测。这两种方法都依赖于经典技术,与现代基于深度学习的方法相比,它们的使用场景往往有限。

文献[23]使用Nvidia Jetson TX1和TX2设备进行交通灯检测,推理速度达到10 FPS。他们的方法还使用了基于颜色的启发式候选区域选择模块来识别感兴趣的区域,并且只在分类部分使用了轻量级卷积神经网络( CNN )。

基准数据集

1 .数据收集

大多数公开可用的交通标志和交通灯数据集都是使用安装在车辆上的摄像头拍摄的视频创建的[ 5 ]或者从谷歌或腾讯等街景服务中提取的图像[35]。为了创建我们的数据集,我们从安装在4辆车内的两个相机中收集视频片段,并手动提取包含交通标志或交通灯的帧。我们在斯里兰卡的城市、农村和高速公路条件下涵盖了广泛的挑战性场景,其中包括不同的天气和光照条件、遮挡和恶化的迹象。

2. 数据注释

我们使用LabelImg [1]图像标注工具将提取的图像中存在的交通标志和交通灯作为边界框进行人工标注。对于每幅图像,以PASCAL VOC [8]格式创建一个XML文件,其中包含交通标志和交通灯实例的边界框标注。

3. 数据集统计

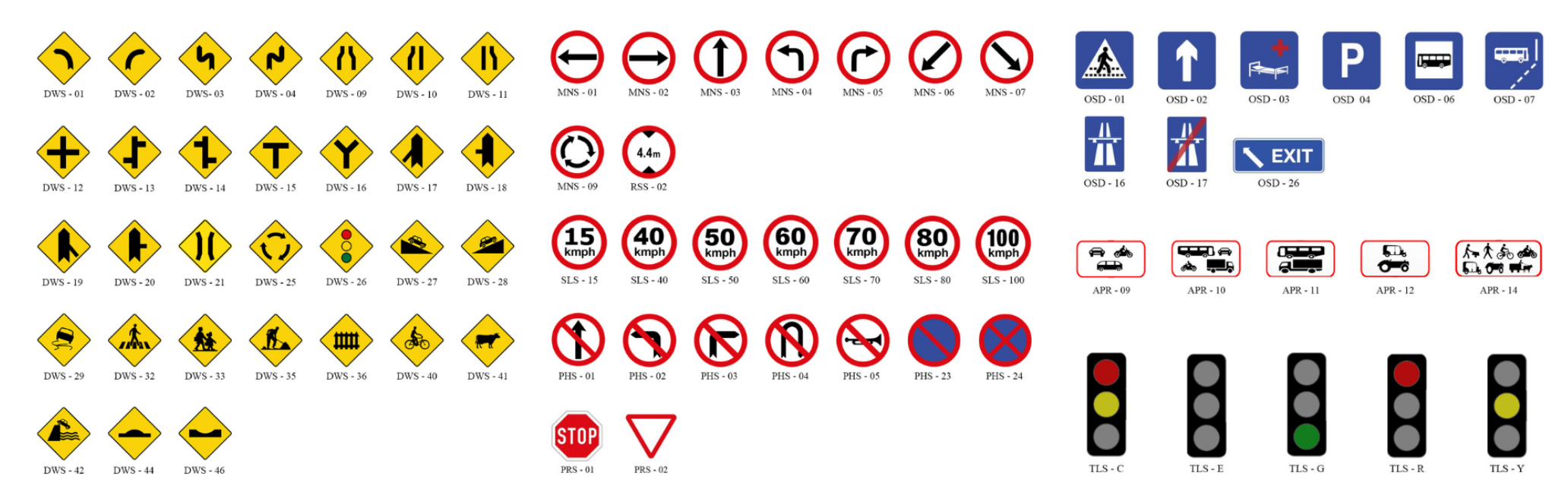

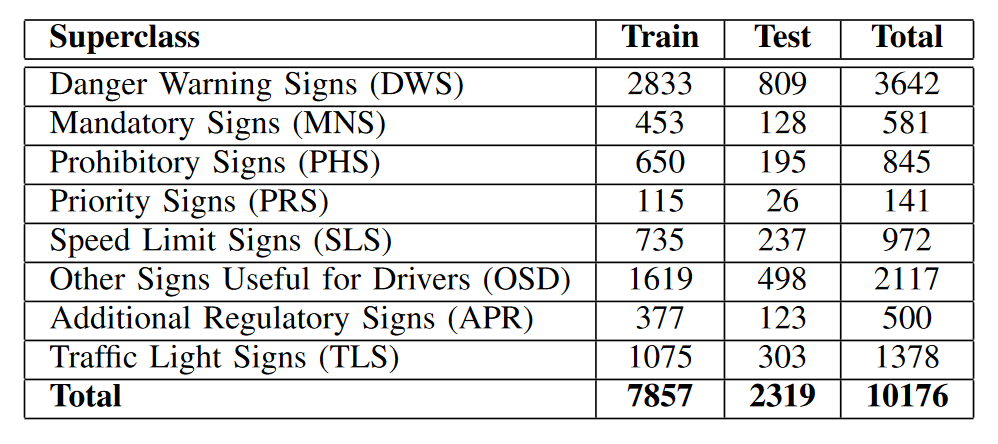

我们的基准数据集由7984张总图像组成,分辨率为1920 × 1080。数据集分为训练集和测试集,分别包含6143张图像和1841张图像。该数据集涵盖了70个不同的交通标志类别和5个交通灯类别,可视化结果如图1所示。由于一些交通标志和交通灯类不经常被发现,数据集中存在固有的类不平衡。总实例数小于25的类已被排除在测试集中。交通标志和交通灯类可以进一步划分为8个超类,每个超类中的实例数量如表III所示。

图1为CeyRo数据集的70个交通标志类和5个交通灯类。

表III: CeyRo数据集中每个超类的实例数。

4. 评估指标

我们使用F1-score作为交通标志和交通灯数据集的评价指标。每一个与真值的交并比( IoU )大于0.3的预测都被认为是真阳性。查准率、查全率和F1-score的计算公式如下:TP、FP、FN分别表示真阳性、假阳性和假阴性的总数。

$$ precision = \frac{TP}{TP+FP} \tag{1} $$

$$ recall=\frac{TP}{TP+FN}\tag{2} $$

$$ \mathbf{F_1\mathbf{-}score}=\frac{2 \times precision \times recall}{precision+recall}\tag{3} $$

方法

1. 模型框架

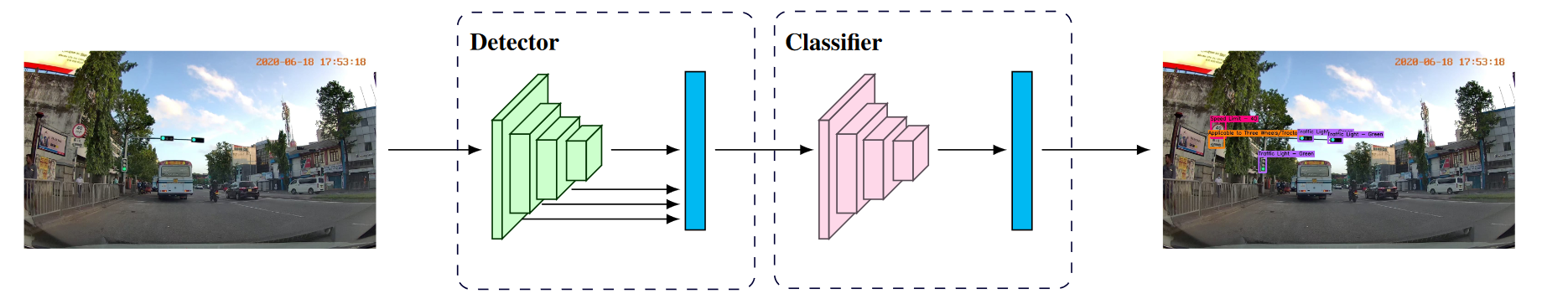

提出的交通标志和交通灯检测模型架构如图2所示。采用最先进的目标检测器模型,首先检测输入图像中存在的交通标志和交通灯作为8个超类下的边界框。然后使用单独的分类器模型将每个检测分类到各自的类中。

图2:交通标志和交通灯检测模型架构。Faster-RCNN-ResNet50网络[ 13 ] [ 28 ]和SSD - MobileNet - v2 [ 20 ] [ 31 ]被评估为目标检测器,首先检测交通标志和交通灯作为其超类下的边界框。然后使用ResNet - 18 [ 13 ]分类器将检测分为各自的类别。

我们评估了两种最先进的目标检测器在交通标志和交通灯检测任务中的性能。Faster R- CNN [ 28 ]作为两级目标检测器,SSD [ 20 ]作为单级目标检测器。将ResNet50网络[ 13 ]作为Faster R- CNN模型的主干,Moblie Net-v2 [ 15 ]作为SSD模型的主干。两种目标探测器模型的输入分辨率均设置为512 × 512。

针对交通标志和交通灯分类任务,训练了一个ResNet - 18 [ 13 ]分类器。输入图像分辨率设置为100 × 100,输出类数设置为75,其中包括70个交通标志类和5个交通灯类。我们的数据集的训练集合中存在的交通标志和交通灯实例被裁剪并提取出来,为分类器创建训练集合。

2. 模型训练

我们使用TensorFlow Object Detection API [ 16 ]来训练两个目标检测器模型。对于SSD - MobileNetv2 [ 20 ],[ 31 ]模型的训练,采用RMSprop算法[ 29 ]优化,初始学习率为0.004,动量为0.9,批大小设置为24。对于训练FasterRCNN - ResNet50网络[ 13 ],[ 28 ]模型,采用带动量[ 32 ]优化的SGD,初始学习率为0.0003,动量为0.9,批次大小设置为8。

ResNet-18 [ 13 ]分类器使用PyTorch [ 25 ]训练30个epoch。采用交叉熵损失作为损失函数,采用学习率为0.01、动量为0.9的SGD算法作为优化函数。批处理大小设置为512。我们使用Intel Core i9-9900K CPU和Nvidia RTX-2080 Ti GPU的计算平台来训练我们的模型。

3. 数据增强

为了减少类不平衡问题的影响,我们使用数据增强技术来增加不太频繁的交通标志和交通信号灯的实例数量。在训练检测器和分类器模型时,使用随机水平翻转作为增强技术,以反映交通标志和交通灯,并在适用的情况下创建新的实例。此外,在训练分类器时使用颜色抖动增强技术随机改变输入图像的亮度、对比度、饱和度和色调。

4. 嵌入式系统实现

我们使用 Nvidia Jetson AGX Xavier 作为嵌入式设备来部署交通标志和交通灯检测系统。检测器和分类器模型由于其资源受限的性质,直接在嵌入式设备上进行推理时速度较低。因此,我们使用带有半精度浮点( FP16 )量化的TensorRT优化对训练好的模型进行优化,以有效利用设备中存在的CUDA和Tensor核心。我们使用SSD - MobileNet - v2 [ 20 ],[ 31 ]模型作为嵌入式系统实现的检测器,因为它比Faster - RCNN - ResNet50网络[ 13 ],[ 28 ]模型快得多。

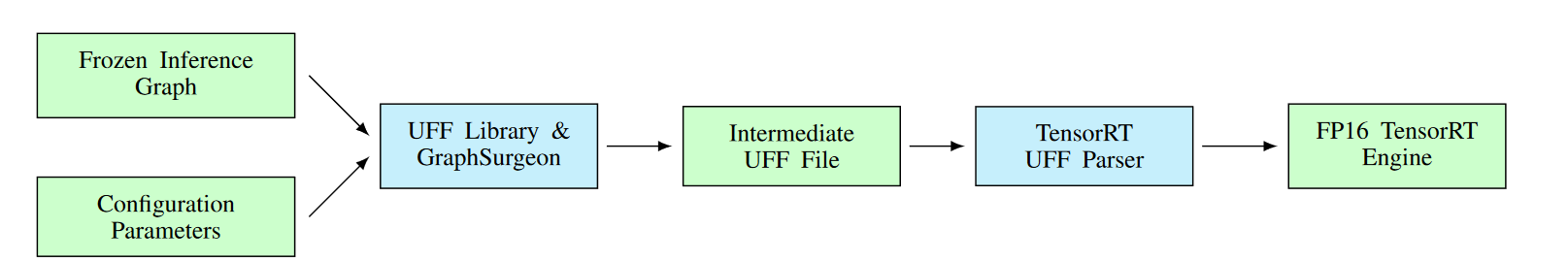

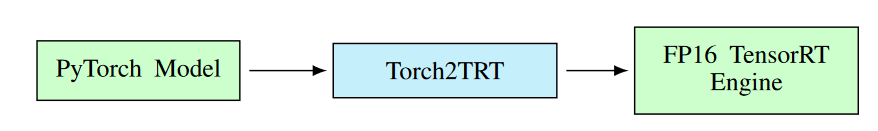

使用TensorFlow Object Detection API [ 16 ]训练的交通标志和交通灯检测模型可以使用TensorRT进行优化,如图3所示。首先,利用冻结推断图和模型的配置参数,使用graphurgeon和UFF库生成UFF格式的中间文件。其次,使用TensorRT Python API中的UFF Parser将中间文件量化为FP16 TensorRT引擎。使用PyTorch [ 25 ]训练得到的分类器模型,可以使用torch2trt [ 2 ]进行优化,如图4所示。使用TensorRT Python API的torch2trt将训练好的. pth文件格式的PyTorch模型直接转换为FP16量化的TensorRT引擎。

图3:使用TensorFlow Object Detection API训练的检测器模型的TensorRT转换和量化过程。

图4:使用PyTorch训练的分类器模型的TensorRT转换和量化过程。

我们在机器人操作系统( ROS ) [ 26 ]生态系统中实现了我们的交通标志和交通灯检测系统,如图5所示。图像馈线节点从给定的视频文件中检索每一帧并发布到输入帧主题。交通标志和交通灯检测节点利用生成的TensorRT引擎检测当前帧中的交通标志和交通灯。然后将检测结果分别发布到交通标志检测和交通灯检测主题。可视化节点在当前帧中标记检测到的交通标志和交通灯,并将生成的图像发布到输出帧主题。利用RViz可视化工具可以对交通标志和交通灯检测进行实时可视化。

结果

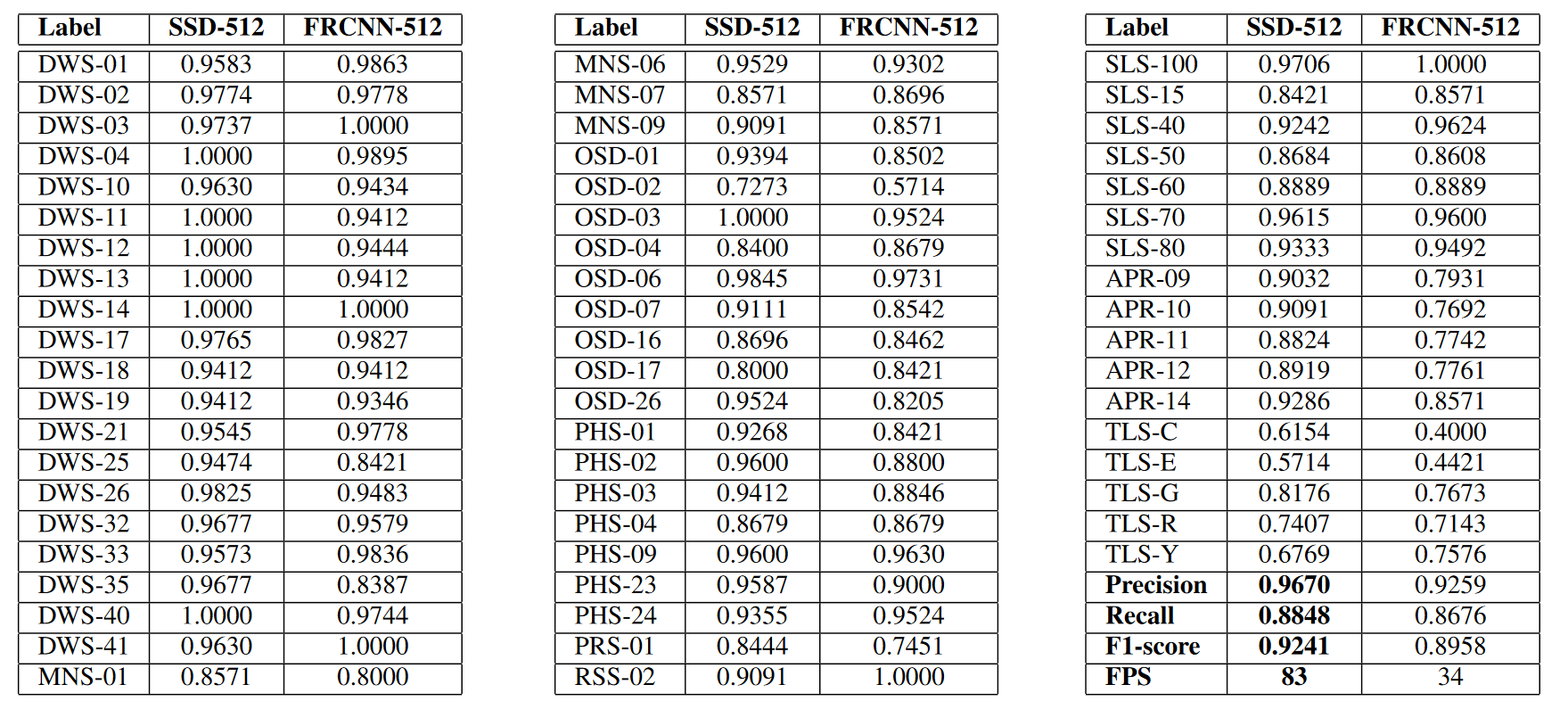

将两个训练好的模型的交通标志和交通灯检测结果列于表四,包括测试集59类的F1-scores、总体精度、总体召回率、总体F1-scores以及在Nvidia RTX-2080Ti GPU工作站上的推理速度。推理速度以1841张测试图像的平均FPS计算。

表IV:交通标志和交通灯检测结果。对于每个检测模型,列出了分类F1-scores、总体精度、总体召回率、总体F1-scores和每秒帧的推理速度( FPS )。

可以观察到SSD - MobileNet - v2 [ 20 ]、[ 31 ]模型比Faster - RCNN - ResNet50网络[ 13 ]、[ 28 ]模型对交通标志和交通信号灯的检测更加准确。这与一般认为两级目标检测器性能优于单级目标检测器的观点相悖。SSDMobileNet-v2 [ 20 ],[ 31 ]模型也取得了比Faster - RCNN - ResNet50网络[ 13 ],[ 28 ]模型高83 FPS的推理速度。部分交通标志和交通灯类的F1值值较低,这主要是由于这些类在列车集合中的实例数量较少。

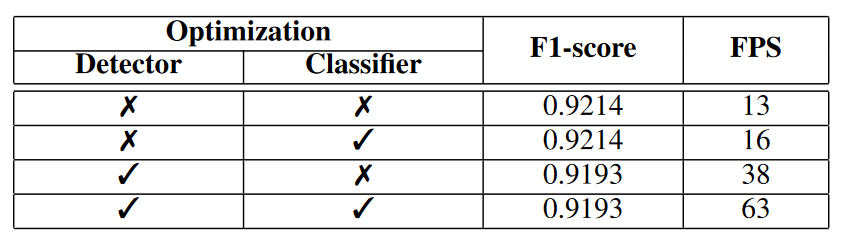

TensorRT优化过程的结果如表V所示,每一行分别表示检测器模型是否优化、分类器模型是否优化以及得到的F1-score和在Nvidia Jetson AGX Xavier设备上的推理速度。可以观察到,在精度略有下降的情况下,通过TensorRT优化和量化检测器和分类器模型,可以显著提高推理速度。

表V:TensorRT优化结果。对于每个组合,列出了产生的F1-score和推理速度。

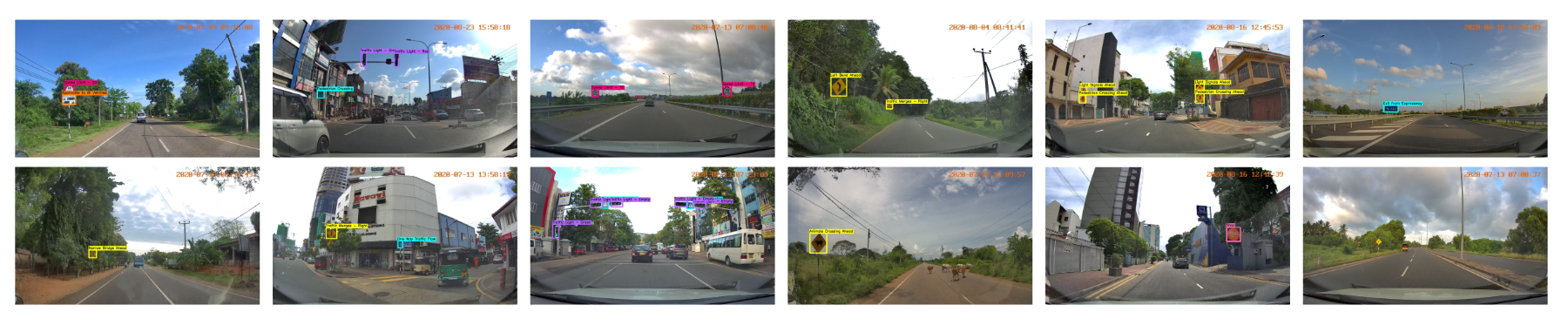

将SSD - MobileNet - v2 [ 20 ],[ 31 ]模型得到的交通标志和交通灯检测任务的部分定性结果在图6中进行了可视化,包括城市、农村、城市、高速公路、眩光和遮挡条件。也包括误检和漏检的例子。

图6:交通标志和交通灯检测结果可视化。前十张图像在不同的道路场景中表现出准确的检测,后两张图像表现出失败的情况,包括错误检测和未检测的情况。

结论

在这项工作中,我们提出了一个简单的、端到端的、基于深度学习的两级检测管道,用于嵌入式系统中的实时交通标志和交通灯检测。此外,我们还介绍了CeyRo交通标志和交通灯数据集,该数据集涵盖了斯里兰卡广泛的具有挑战性的道路场景。我们的基准包含7984张总图像和10176个交通标志和交通灯实例,分属于70个交通标志类和5个交通灯类。使用定性和定量结果证明了所提框架的有效性。我们进一步展示了我们的系统在使用Nvidia Jetson AGX Xavier设备的嵌入式系统中提供实时性能的能力。使用TensorRT优化检测模型,并与Robot Operating System集成,部署为交通标志和交通灯检测系统,实现了63 FPS的高推理速度。我们相信这是在计算资源有限的挑战性道路场景中实现实时交通标志和交通灯检测的一个很有前途的步骤。

[1] LabelImg. https://github.com/tzutalin/labelImg.

[2] torch2trt. https://github.com/NVIDIA-AI-IOT/torch2trt.

[3] M. Bach, D. Stumper, and K. Dietmayer. Deep convolutional traffic light recognition for automated driving. In 21st International Conference on Intelligent Transportation Systems, pages 851–858, 2018.

[4] D. Barnes, W. Maddern, and I. Posner. Exploiting 3d semantic scene priors for online traffic light interpretation. In IEEE Intelligent Vehicles Symposium (IV), pages 573–578, 2015.

[5] K. Behrendt, L. Novak, and R. Botros. A deep learning approach to traffic lights: Detection, tracking, and classification. In IEEE International Conference on Robotics and Automation (ICRA), pages 1370–1377, 2017.

[6] A. Ellahyani, M. E. Ansari, I. E. Jaafari, and S. Charfi. Traffic sign detection and recognition using features combination and random forests. International Journal of Advanced Computer Science and Applications, 7, 2016.

[7] C. Ertler, J. Mislej, T. Ollmann, L. Porzi, G. Neuhold, and Y. Kuang. The mapillary traffic sign dataset for detection and classification on a global scale. In European Conference on Computer Vision (ECCV), pages 68–84, 2020.

[8] M. Everingham, S. M. A. Eslami, L. V. Gool, C. K. I. Williams, J. Winn, and A. Zisserman. The pascal visual object classes challenge: A retrospective. International Journal of Computer Vision, 111(1):98136, 2015.

[9] A. Fregin, J. Muller, U. Krebel, and K. Dietmayer. The driveu traffic light dataset: Introduction and comparison with existing datasets. In IEEE International Conference on Robotics and Automation (ICRA), pages 3376–3383, 2018.

[10] R. Girshick. Fast r-cnn. In IEEE International Conference on Computer Vision (ICCV), pages 1440–1448, 2015.

[11] A. E. Gomez, F. A. R. Alencar, P. V. Prado, F. S. Os ́ orio, and D. F. Wolf. Traffic lights detection and state estimation using hidden markov models. In IEEE Intelligent Vehicles Symposium (IV), pages 750–755, 2014.

[12] K. He, G. Gkioxari, P. Doll ́ ar, and R. Girshick. Mask r-cnn. In 2017 IEEE International Conference on Computer Vision (ICCV), pages 2980–2988, 2017.

[13] K. He, X. Zhang, S. Ren, and J. Sun. Deep residual learning for image recognition. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pages 770–778, 2016.

[14] S. Houben, J. Stallkamp, J. Salmen, M. Schlipsing, and C. Igel. Detection of traffic signs in real-world images: The German Traffic Sign Detection Benchmark. In International Joint Conference on Neural Networks, 2013.

[15] A. G. Howard, M. Zhu, B. Chen, D. Kalenichenko, W. Wang, T. Weyand, M. Andreetto, and H. Adam. Mobilenets: Efficient convolutional neural networks for mobile vision applications. arXiv preprint arXiv:1704.04861, 2017.

[16] J. Huang, V. Rathod, C. Sun, M. Zhu, A. Korattikara, A. Fathi, I. Fischer, Z. Wojna, Y. Song, S. Guadarrama, and K. Murphy. Speed/accuracy trade-offs for modern convolutional object detectors. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pages 7310–7311, 2017.

[17] M. Jensen, M. Philipsen, Chris C. H. Bahnsen, A. Møgelmose, T. Moeslund, and M. Trivedi. Traffic light detection at night: Comparison of a learning-based detector and three model-based detectors. In International Symposium on Visual Computing, pages 774–783, 2015.

[18] U. Kamal, T. I. Tonmoy, S. Das, and M. K. Hasan. Automatic traffic sign detection and recognition using segu-net and a modified tversky loss function with l1-constraint. IEEE Transactions on Intelligent Transportation Systems, 21(4):1467–1479, 2020.

[19] J. Li, X. Liang, Y. Wei, T. Xu, J. Feng, and S. Yan. Perceptual generative adversarial networks for small object detection. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pages 1951–1959, 2017.

[20] W. Liu, D. Anguelov, D. Erhan, C. Szegedy, S. Reed, C.-Y. Fu, and A. C. Berg. Ssd: Single shot multibox detector. In European Conference on Computer Vision (ECCV), pages 21–37, 2016.

[21] S. Maldonado-Bascon, S. Lafuente-Arroyo, P. Gil-Jimenez, H. GomezMoreno, and F. Lopez-Ferreras. Road-sign detection and recognition based on support vector machines. IEEE Transactions on Intelligent Transportation Systems, 8(2):264–278, 2007.

[22] A. Mogelmose, M. M. Trivedi, and T. B. Moeslund. Vision-based traffic sign detection and analysis for intelligent driver assistance systems: Perspectives and survey. IEEE Transactions on Intelligent Transportation Systems, 13(4):1484–1497, 2012.

[23] Z. Ouyang, J. Niu, Y. Liu, and M. Guizani. Deep cnn-based real-time traffic light detector for self-driving vehicles. IEEE Transactions on Mobile Computing, 19(2):300–313, 2020.

[24] G. Overett and L. Petersson. Large scale sign detection using hog feature variants. In IEEE Intelligent Vehicles Symposium (IV), pages 326–331, 2011.

[25] A. Paszke, S. Gross, F. Massa, A. Lerer, J. Bradbury, G. Chanan, T. Killeen, Z. Lin, N. Gimelshein, L. Antiga, A. Desmaison, A. Kopf, E. Yang, Z. DeVito, M. Raison, A. Tejani, S. Chilamkurthy, B. Steiner, L. Fang, J. Bai, and S. Chintala. Pytorch: An imperative style, highperformance deep learning library. In Advances in Neural Information Processing Systems, pages 8024–8035. 2019.

[26] M. Quigley, K. Conley, B. P. Gerkey, J. Faust, T. Foote, J. Leibs, R. Wheeler, and A. Y. Ng. Ros: an open-source robot operating system. In ICRA Workshop on Open Source Software, 2009.

[27] J. Redmon, S. Divvala, R. Girshick, and A. Farhadi. You only look once: Unified, real-time object detection. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pages 779–788, 2016.

[28] S. Ren, K. He, R. Girshick, and J. Sun. Faster r-cnn: Towards real-time object detection with region proposal networks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 39(6):1137–1149, 2017.

[29] S. Ruder. An overview of gradient descent optimization algorithms. arXiv preprint arXiv:1609.04747, 2016.

[30] S. S. M. Sallah, F. A. Hussin, and M. Z. Yusoff. Road sign detection and recognition system for real-time embedded applications. In International Conference on Electrical, Control and Computer Engineering (InECCE), pages 213–218, 2011.

[31] M. Sandler, A. Howard, M. Zhu, A. Zhmoginov, and L.-C. Chen. Mobilenetv2: Inverted residuals and linear bottlenecks. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pages 4510–4520, 2018.

[32] I. Sutskever, J. Martens, G. Dahl, and G. Hinton. On the importance of initialization and momentum in deep learning. In 30th International Conference on Machine Learning, pages 1139–1147, 2013.

[33] D. Tabernik and D. Skoˇ caj. Deep learning for large-scale trafficsign detection and recognition. IEEE Transactions on Intelligent Transportation Systems, 21(4):1427–1440, 2020.

[34] X.-H. Wu, R. Hu, and Y.-Q. Bao. Parallelism optimized architecture on fpga for real-time traffic light detection. IEEE Access, 7:178167178176, 2019.

[35] Z. Zhu, D. Liang, S. Zhang, X. Huang, B. Li, and S. Hu. Trafficsign detection and classification in the wild. In IEEE Conference on Computer Vision and Pattern Recognition (CVPR), pages 2110–2118, 2016.

这是一篇论文吗